Wann wird der Roboter für den Menschen zum echten Kumpel?

Roboter werden in den nächsten Jahrzehnten immer wichtiger werden. Sie könnten etwa für bestimmte Pflegedienste genutzt werden, aber auch als "Soldaten" oder gar als "Sex-Arbeiter". Darum ist es wichtig zu wissen, wie ein Roboter beschaffen sein muss, damit er von uns Menschen überhaupt als echter Kumpel wahrgenommen werden kann.

Das Team um Sören Krach von der RWTH Aachen hatte 20 Männer im Alter von etwa 25 Jahren zu einem Computer-Spiel eingeladen, das das aus der Spieltheorie bekannte "Gefangenen-Dilemma" aufnimmt: Zwei Gefangene werden verdächtigt, gemeinsam eine Straftat begangen zu haben. Die Höchststrafe für das Verbrechen beträgt fünf Jahre. Beiden Gefangenen wird nun folgender Handel angeboten, worüber auch beide informiert sind: Wenn einer gesteht und dadurch seinen Partner mitbelastet, kommt er ohne Strafe davon - der andere muss die vollen fünf Jahre absitzen. Entscheiden sich beide zu schweigen, bleiben nur Indizienbeweise, die aber ausreichen, um beide für zwei Jahre einzusperren. Gestehen aber beide die Tat, erwartet jeden eine Gefängnisstrafe von vier Jahren. Die Gefangenen müssen sich nun, ohne sich miteinander absprechen zu können, für eine Option entscheiden und müssen dabei aber die mögliche Reaktion des anderen einkalkulieren. Sie müssen sich also beispielsweise Fragen stellen wie: "Ich würde wohl schweigen, aber kann ich mich darauf verlassen, dass mein Kumpel auch schweigt?"

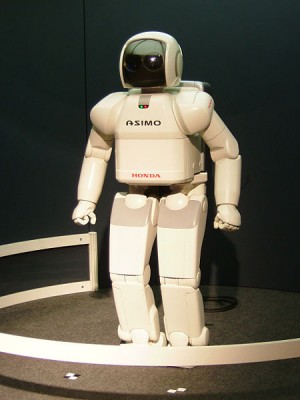

Im Experiment des Forscherteams saß nun ein Proband vor einem Computer einem angeblichen anderen Probanden gegenüber (dieser gehörte aber in Wirklichkeit zum Forscherteam). In der Spieler-Runde befanden sich außerdem ein funktional gestalteter Roboter hinter einem Notebook, ein Notebook allein und ein menschenähnlich gestalteter Roboter, der ebenfalls hinter einem Notebook saß. Ein Kabel verband alle Notebooks miteinander. Was die echten Probanden nicht wussten: Das Kabel war nur zum Schein da. In Wirklichkeit waren alle Notebooks außer dem des jeweiligen Probanden und alle Roboter vorher so programmiert worden, dass sie genau dann "reagierten", wenn der Proband meinte, dass sie reagierten. Ihre "Entscheidungen" im Gefangenen-Dilemma standen also vorher fest und waren alle gleich.

Im Verlauf des Experiments wurden die Gehirnaktivitäten der Probanden mit Hilfe von Magnetresonanz-Tomografie beobachtet. Dabei zeigte sich, dass die für menschliche Interaktion zuständigen Gehirnregionen - die rechte temporal-parietalen Verbindung und der medio-präfrontale Cortex - umso stärker aktiv waren, je menschenähnlicher der Roboter war, mit dem er glaubte, es gerade zu tun zu haben. Außerdem sollten die Probanden nach dem Experiment einen Fragebogen zu ihren Erfahrungen ausfüllen. Dabei bescheinigten die Probanden dann dem menschenähnlichen Roboter, der Intelligenteste gewesen zu sein (obwohl er nicht anders programmiert war als die anderen Roboter und Computer). Der Mensch könnte also wohl dazu gebracht werden, auch einem Roboter zu vertrauen und sich von ihm helfen zu lassen. Doch dafür wäre es unabdingbar, dass der Roboter so menschenähnlich gestaltet wird wie möglich.

Was Sie schon immer über Mikroben wissen wollten

Was Sie schon immer über Mikroben wissen wollten Energiewende: Schluss mit Schwarz-Weiß-Strategien

Energiewende: Schluss mit Schwarz-Weiß-Strategien Nicole Bender und Lotte Habermann-Horstmeier: Evolution und Gesundheit

Nicole Bender und Lotte Habermann-Horstmeier: Evolution und Gesundheit